- En una actualización de su política de uso, la compañía mantiene el veto al desarrollo de armas, pero borra la referencia al uso militar y bélico

- La compañía asegura que su propósito es aportar pautas “más legibles” y orientaciones específicas

OpenAI cambia el tono de su política de uso en lo que a aplicaciones militares y bélicas se refiere. En una actualización reciente de las pautas que da a sus usuarios, la compañía liderada por Sam Altman ha aplicado un cambio pequeño, casi, casi de terminología, pero que resulta significativo: ha suprimido la mención explícita que prohibía el uso de su tecnología en actividades “militares” y de “guerra”.

La organización, detrás del popular ChatGPT, mantiene el veto al “desarrollo y uso de armas”, aunque ahora prescinde de los términos bélicos que antes sí figuraban en su política de uso. El cambio, claro está, no ha pasado desapercibido.

Actualizando la política de uso. No es extraño que una compañía como OpenAI aplique cambios en sus políticas de uso a medida que evoluciona la propia tecnología que ofrece. Si accedes a su web y consultas al apartado correspondiente podrás consultar un “registro de cambios” en el que se desgranan casi una docena desde febrero de 2021. Hace poco más de un año, por ejemplo, en febrero de 2023, la compañía decidió modificar sus “casos de uso y políticas de contenido” y concretó qué actividades no autoriza en industrias de “alto riesgo”.

El último cambio en las políticas de uso data de hace solo unos días, del miércoles 10 de enero, y se presenta como una actualización de las pautas para que resulten “más claras” y aporten una “orientación más específica” a los usuarios.

Donde dije militar y guerra… Las novedades aplicadas por la compañía no pasaron inadvertidas a Sam Biddle, reportero The Intercept, quien ayer publicó un artículo haciéndose eco de la modificación tan sutil como significativa aplicada por el equipo de Altman. El cambio, asegura Biddle, se concretó el 10 de enero.

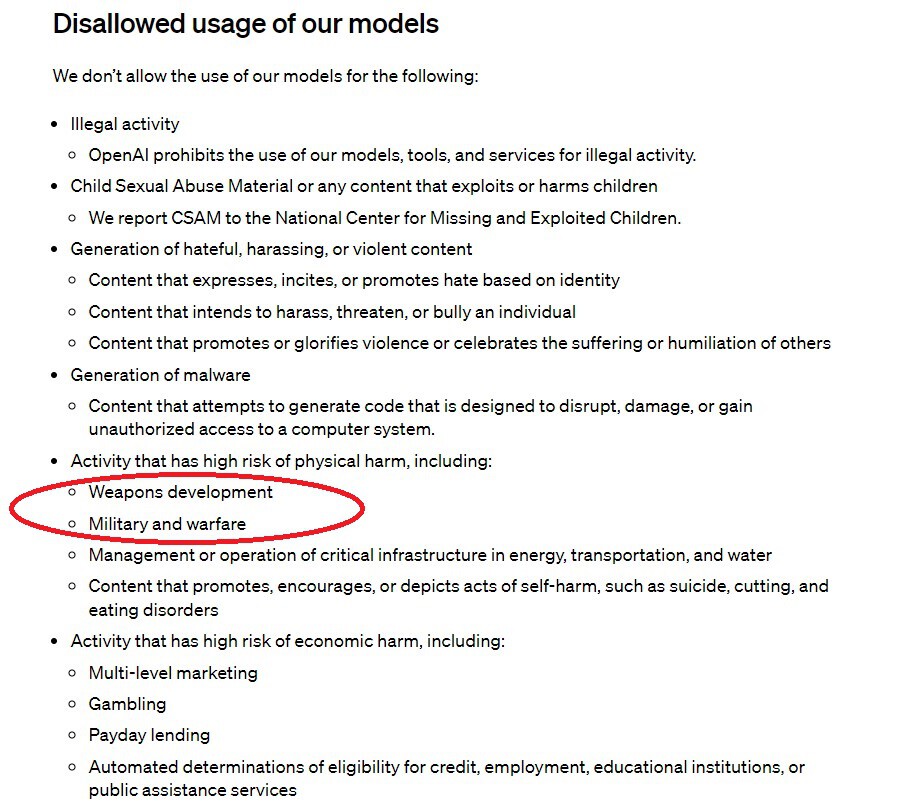

Hasta ese momento la política de uso de OpenAI recogía con claridad mediriana que uno de los usos que no autorizaba la compañía era el “militar y bélico”. Ambos términos se incluían en el apartado de actividades con “alto riesgo de daño físico”, en el que también se citaba de forma expresa el “desarrollo de armas” y todo aquel contenido que “promueva, fomente o represente actos de autolesión”.

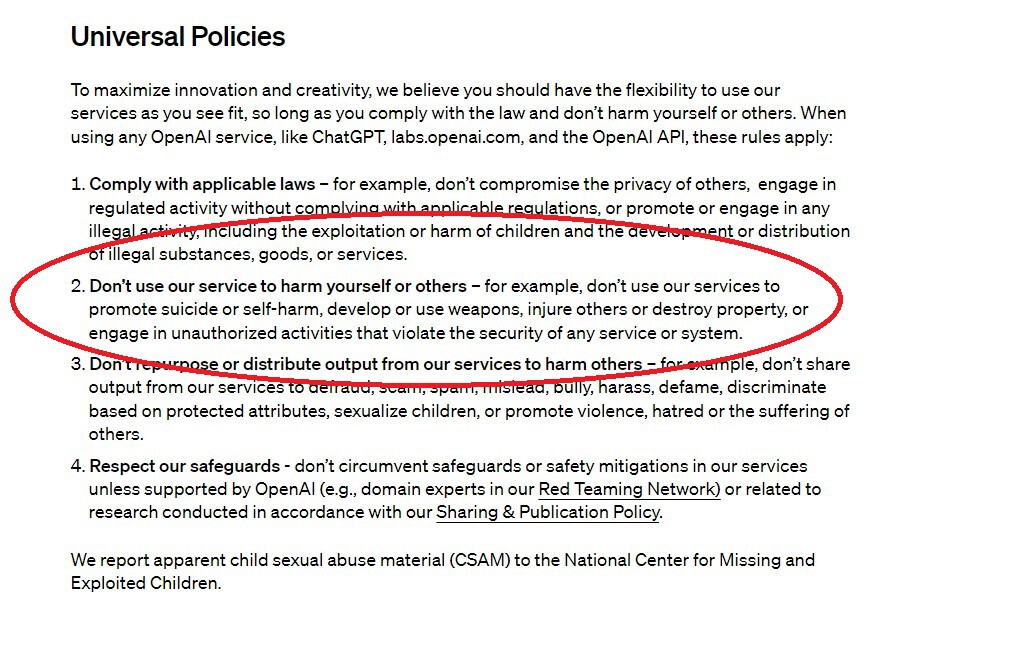

… Digo solo armas. Ahora la redacción de la política de uso es significativamente distinta y suprime ambos términos: militar y bélico. En su lugar, OpenAI incluye un epígrafe en el que prohíbe que la gente recurra a su tecnología para causarse daño a sí misma u a otras personas: “Por ejemplo, no utilice nuestros servicios para promover el suicido o la autolesión, desarrollar o usar armas, herir a otros o destruir propiedad, ni participar en actividades no autorizadas que violen la seguridad de cualquier servicio o sistema”. La nueva redacción mantiene la mención al desarrollo de armas, no el uso militar.

Pero… ¿Cómo interpretar el cambio? Esa es la pregunta del millón. Las políticas de uso OpenAI ha experimentado más cambios y la compañía asegura que el objetivo es que sean “más claras” y aporten una “orientación específica” sobre el servicio. “Nuestro propósito era crear un conjunto de principios universales que fueran fáciles de recordar y aplicar, especialmente porque nuestras herramientas ahora son utilizadas globalmente por usuarios cotidianos que ahora también pueden construir GPT”, asegura Niko Felix, portavoz de la compañía.

La relevancia del cambio no ha pasado desapercibida sin embargo a medios estadounidenses como TechCrunch o la propia The Intercept, que lo interpreta como una “suavización” del veto al uso militar y asegura que el Pentágono mira con atención a la compañía liderada por Altman, peso pesado en el terreno de la IA y que cuenta con un respaldo multimillonario de Microsoft, que entre sus servicios publicita tecnología para “defensa e inteligencia” y ha recibido, junto a Amazon, Google y Oracle, unos 9.000 millones de contratos del Pentágono.

De interpretaciones y usos. “Hay una clara diferencia entre las dos políticas, ya que la primera establece con claridad que el desarrollo de armas y la guerra militar están prohibidos; la segunda hace hincapié en la flexibilidad y el cumplimiento de la ley”, señala a The Intercept Heidy Khlaaf, de la firma de ciberseguridad Trail of Bits. Opinión similar traslada Lucy Suchman, de la Universidad de Lancaster, quien desliza que el cambio “deja abierto un espacio” para que OpenAI pueda apoyar “infraestructuras operativas” sin el desarrollo directo de armamento.

La organización de noticias estadounidense recuerda que, si bien ninguna de la tecnología que ofrece OpenAI puede usarse para matar a alguien, hay tareas que una herramienta como ChatGPT podría aligerar, entre las que se incluye escribir código o tramitar pedidos. Los recursos de OpenAI resultarían útiles también, por ejemplo, para trabajar con rapidez con grandes cantidades de documentación.

Fuente: Xataka News